NVIDIA GeForce RTX 4090 - test karty graficznej. Sprawdzamy niereferenta od KFA2!

Przez ostatnie kilka dni testowałem kartę graficzną NVIDIA GeForce RTX 4090, na którą zresztą z niecierpliwością czekałem. Specjalnie w tym celu nieco zmodyfikowałem sprzęt testowy, dokładając mocniejszy zasilacz i wymieniając procesor, by móc bez większych przeszkód doświadczyć gigantycznej wydajności. Przeskok względem poprzedniej serii jest doprawdy imponujący, a grafika wcale nie pożera tak wiele prądu, jak RTX 3090 Ti. Ba, charakteryzuje się nawet lepszą efektywnością energetyczną. Zapraszam na test.

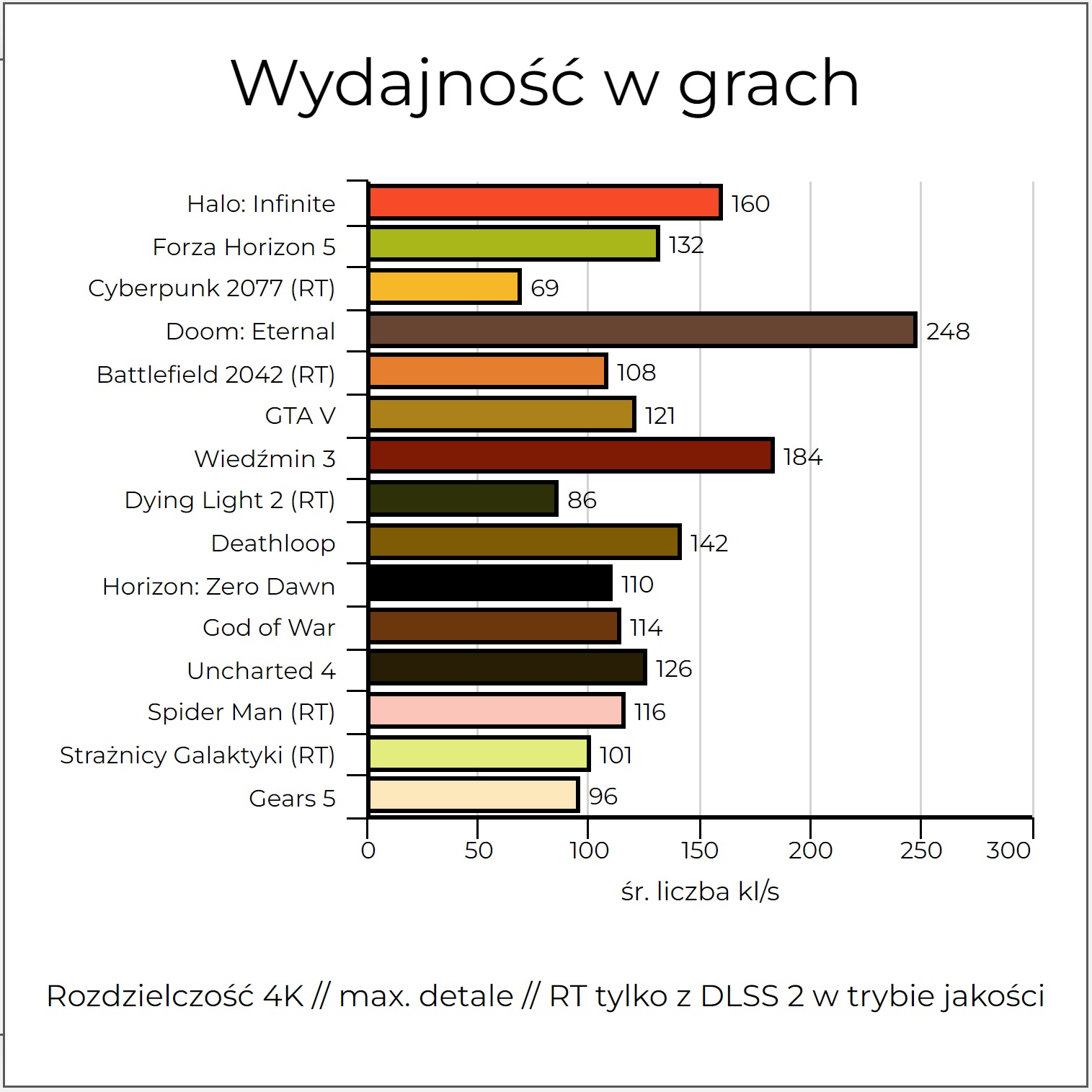

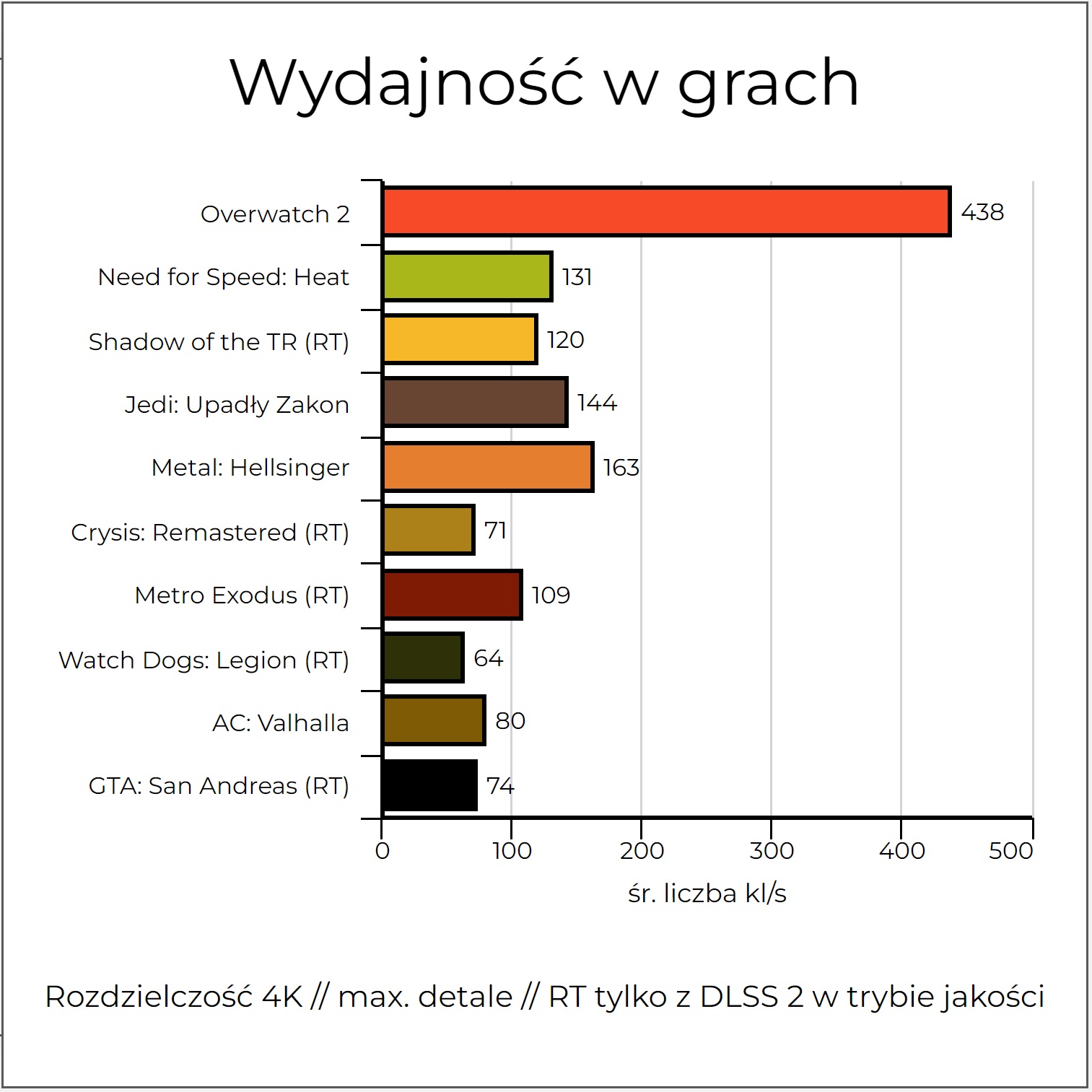

Mógłbym tutaj zacząć przede wszystkim od szczegółowego wprowadzenia i opisu architektury najnowszych kart z rodziny Ada Lovelace, ale postanowiłem skoncentrować się głównie na testach wydajności w najpopularniejszych grach na rynku. W końcu jesteśmy serwisem gamingowym i to właśnie ten aspekt, w mojej ocenie, interesuje naszych czytelników najbardziej. Na moją listę trafiło 25 najbardziej rozchwytywanych tytułów, które postanowiłem sprawdzić w zestawieniu z monitorem 4K od Philipsa, którego częstotliwość odświeżania matrycy wynosi 144 Hz. Pozostałe elementy platformy testowej składały się z procesora Intel Core i7-12700K podkręconego do 5,2 GHz, 32GB pamięci RAM DDR4 3600 MHz CL16, zasilacza o mocy 1000W z certyfikatem 80 Plus Gold, a także solidnej płyty głównej od Gigabyte. Nie mogłem niestety sprawdzić najnowszej techniki DLSS 3 w akcji, ale chciałbym zaznaczyć, że nawet bez tego praktycznie każda gra działała z kosmiczną liczbą klatek na sekundę. Przeskok względem RTX 3080, którego do tej pory wykorzystuje, był wręcz abstrakcyjny. Przejdźmy więc do rzeczy. Poniżej widzicie porównanie z jedną z najpopularniejszych kart graficznych, czyli RTX 3060.

Najnowsze układy graficzne od NVIDIA przeszły szereg istotnych usprawnień względem poprzedniej rodziny o nazwie kodowej Ampere. Przede wszystkim znacznie zwiększono taktowania rdzenia, którego prędkość sięga teraz mitycznych 3000 MHz. Ponadto znajdziemy tu więcej pamięci cache drugiego poziomu, całkowicie przebudowane jednostki RT 3. generacji oraz Tensor 4. generacji, a także bardzo rozbudowany i wspomagany tryb DLSS, którego trzecia iteracja zadziała wyłącznie na kartach z rodziny Ada Lovelace przez obecność nowych jednostek obliczeniowych. Wydajność tej techniki jest natomiast spektakularna, bowiem sięga blisko 400% względem poprzednika, czyli RTX 3090, co uważam za jakiś absurdalny rezultat. Już samo podniesienie zegarów rdzenia powinno zauważalnie poprawić wydajność, a to przecież nie koniec. Zadbano też o lepszą efektywność energetyczną dzięki wykorzystaniu 4 nm procesu litograficznego od TSMC, który pozwolił także na upakowanie blisko 2,5x więcej tranzystorów. Poniżej garść kluczowych danych technicznych.

Specyfikacja techniczna układu NVIDIA GeForce RTX 4090 od KFA2

Układ graficzny: AD102 (Ada Lovelace)

Taktowanie rdzenia: 2520 MHz (w trybie boost)

Taktowanie pamięci: 1325 MHz (ok. 21200 MHz)

Ilość pamięci VRAM: 24 GB GDDR6X

Szyna danych: 384-bit

Proces technologiczny: 4 nm

Liczba tranzystorów: 76 mld

Liczba rdzeni CUDA: 16384 (poprzednik, czyli RTX 3090 Ti miał 10752)

Liczba jednostek TMU: 512

Liczba jednostek ROP: 176

Liczba jednostek RT: 128

Liczba rdzeni Tensor: 512

Pamięć Cache L2: 96 MB (względem 6 MB u poprzednika)

Przepustowość pamięci: ok. 1 TB/s

TDP: 450W

Złącze: PCI-E 4.0

Cena: ok. 11 tysięcy złotych

To wszystko przekłada się na teoretyczną wydajność przekraczającą 82,5 TFLOPs, czyli blisko 8-krotnie wyższą od możliwości konsoli PlayStation 5. Muszę przyznać, że już na samym starcie, zaraz po wypakowaniu tej karty graficznej z pudełka doznałem dużego szoku. Jest doprawdy olbrzymia. Waży blisko 2 kg i w zestawie znajduje się nawet specjalny wspornik, który obowiązkowo musimy zastosować, by nasz slot na PCI-E nie został wykrzywiony (lub co gorsza, wyłamany). Grafika ma trzy duże wentylatory, piękne i rozbudowane podświetlanie RGB, a także możliwość dołożenia czwartego "wiatraka" na spodzie, gdy zechcemy zwiększyć wartość TDP do 500W. Do zasilenia tego układu rekomendowany jest renomowany zasilacz o mocy 850W, a także znakomita cyrkulacja powietrza w obudowie, bo karta wydziela ogromne ilości ciepła.

Galeria

Wygląd i wykonanie, a także kilka słów o taktowaniach, głośności i możliwościach OC

Model od KFA2, który zawitał do naszej redakcji i do mojej platformy testowej jest zaskakująco dobrze wykonany. Jak możecie zobaczyć na poniższych zdjęciach, karta jest większa od konsoli XSX, znacznie też przewyższając wielkość Nintendo Switch, a nawet Steam Decka. Zajmuje aż trzy sloty w obudowie i do zasilania wymaga podłączenia specjalnego, nowego 12-pinowego złącza od NVIDIA. Jeżeli nie mamy zasilacza "nowej generacji" kompatybilnego z tym połączeniem, musimy wykorzystać przejściówkę dostępną w zestawie, która wymaga podpięcia aż czterech 8-pinowych kabli. W obudowie wyglądało to doprawdy komicznie, a musicie zwrócić uwagę, czy Wasz zasilacz w ogóle ma aż 4 takie złącza. Gdy wszystko zdołałem zamontować w obudowie, mogłem wreszcie przejść do właściwych testów.

Na początek sprawdziłem temperatury i głośność pod obciążeniem. Wentylatory rozpędzały się do maksymalnie 1450 RPM, generując przy tym ok. 41 dBa hałasu. To poziom szeptu, więc w mojej ocenie wynik bardzo akceptowalny. Co ciekawe, dokładając czwarty wentylator, można nieznacznie zbić te wartości. Wtedy wszystkie cztery wentylatory rozkręcają się do ok. 1300 RPM, a to pozwala na uzyskanie 38,6 dBa. Wygląd takiego tandemu wygląda wręcz abstrakcyjnie, ale w komputerze mamy przecież prawdziwą bestię i jak zobaczycie po wynikach wydajności - można pozwolić sobie nawet na takie rozwiązania. Zegar na rdzeniu w trybie boost rozpędzał się nawet do 2750 MHz w rozdzielczości 4K. W trakcie OC mogłem go podnieść do ok. 2900 MHz, więc byłem już bardzo blisko osiągnięcia tych "mitycznych" 3 GHz na rdzeniu, co uważam za kosmiczny rezultat.

Testowana dziś karta w spoczynku działa pasywnie. Ponadto rozgrzewa się do ok. 66 stopni po blisko godzinnej rozgrywce. Cała platforma testowa pobierała w tym momencie blisko 660W, z czego karta graficzna zjadała ponad 415W. Chociaż wydaje się to dużo, to przypominam, że niektóre modele niereferencyjne RTX 3090 Ti potrafiły pobierać jeszcze więcej energii, zatem możemy mówić o wyraźnym usprawnieniu. W końcu przy takiej mocy, takich taktowaniach i tak wielkiej liczbie tranzystorów to nie lada sztuka, by osiągnąć taki wynik. Temperatura w zamkniętej obudowie w trakcie testów potrafiła dobić nawet do 52 stopni, co nie było zdrowe dla któregokolwiek z komponentów i wymusiło na mnie dołożenie dodatkowych dwóch wentylatorów. Co ciekawe, modele z serii RTX 4000 nie są wyposażone w najnowsze złącza DisplayPort 2.0, dalej bazując na wersji 1.4a - to dziwne, bo nawet AMD w obecnej generacji kart graficznych wykorzystuje już nowszą wersję. Na szczęście nie zabrakło HDMI 2.1. Muszę przyznać, że pod względem czysto technicznym, model KFA2 zrobił na mnie piorunujące wrażenie. Myślałem, że to będzie wręcz zabójca dla zasilacza i dodatkowy grzejnik w pomieszczeniu osiągający abstrakcyjne temperatury. Nic z tych rzeczy. Tylko ta cena jest kosmiczna...

Testy wydajności w najpopularniejszych grach - sprawdziłem 25 tytułów w rozdzielczości 4K i z wykorzystaniem RT

Tak, jak wspominałem na początku, nie mogłem niestety zweryfikować działania techniki DLSS 3.0, ale mam nadzieję, że w niedalekiej przyszłości wrócę do Was z konkretnymi testami. Pomiary wydajności przeprowadziłem wyłącznie w rozdzielczości 4K. Odpuściłem zupełnie 1080p (gdzie i tak bardzo wąskim gardłem był procesor), a 1440p jest rozdzielczością stworzoną bardziej dla układów RTX 4080 - w mojej ocenie. Tutaj mówimy o najpotężniejszym GPU na rynku, więc chciałem zobaczyć absolutny TOP możliwości współczesnych, gamingowych PC. Tam, gdzie mogłem włączyć RT, uruchamiałem go na maksymalnych detalach z włączonym DLSS w trybie jakości. W grach od Sony takich jak Uncharted 4, Spider-Man Remastered, God of War czy Horizon: Zero Dawn postanowiłem z DLSS całkiem zrezygnować, bo jego obecność, nawet przy rozdzielczości 4K, delikatnie rozmazywała obraz, a to nie wyglądało zbyt przyjemnie. Co ciekawe, w pozostałych tytułach niczego takiego nie doświadczyłem.

Jak widzicie, można jedynie zbierać szczękę z podłogi. W Cyberpunku 2077 na maksymalnych detalach z włączonym RT w trybie niewiarygodnym i z DLSS 2.0 ustawionym na jakość, klatki wahały się pomiędzy 65, a 80. Mój RTX 3080 w takich warunkach generuje przy tej konfiguracji ok. 29 FPS. W pozostałych tytułach przeskok był jeszcze większy, wręcz niewyobrażalny. Mogłem komfortowo grać w absolutnie każdą grę w 4K, często notując absurdalne wartości i muszę przyznać, że zabawa w takich warunkach jest doprawdy kapitalna. Trudno tu na cokolwiek narzekać, gdy w Halo: Infinite w 4K na maksymalnych ustawieniach mamy ponad 160 klatek, a Forza Horizon 5 to średnio 130 klatek. Gdyby nie ta cena, prawdopodobnie sam próbowałbym kupić dla siebie taką kartę, bo jej wydajność potrafi kompletnie odmienić postrzeganie gamingu na PC, a przecież DLSS 3.0 pozwoli na uzyskanie dodatkowych 80 do 100 klatek w niektórych pozycjach. Brzmi to dla mnie absurdalnie, ale dostępne w sieci wstępne testy pokazują, że wszystko się zgadza. Granie w Cyberpunka w 4K w ponad 120 klatkach? Dlaczego nie?

A jak wypada sama karta od KFA2? W niektórych momentach słyszałem piszczące cewki, ale w ogólnym rozrachunku jest wielka, świetnie wykonana i budzi duży respekt. Nie nagrzewa się zbytnio, zachowuje przy tym przyzwoite temperatury i jest pięknie podświetlana. Chwała dla producenta za dorzucenie dodatkowego wentylatora do zestawu i wspornika, który w tym przypadku jest dosłownie niezbędny. Nawet wartości OC, choć niewielkie, warte są odnotowania. Dla mnie to jednak sztuka dla sztuki, bo nie mam pojęcia, po co komuś przy tej wydajności jeszcze podkręcać ten i tak już wyżyłowany zegar. Za cenę, piszczące cewki i mimo wszystko wymogi posiadania potężnego zasilacza nieco obniżam ocenę, ale w ogólnym rozrachunku RTX 4090 to nowy król wydajności, który zmiana z powierzchni ziemi wszystkie pozostałe karty od NVIDIA i AMD, jakie do tej pory pojawiły się na rynku. Czekamy więc na odpowiedź z obozu czerwonych.

Atuty

- Niesamowita, niedościgniona wydajność

- Idealna do grania w 4K i często powyżej 100-120 klatek na sekundę

- Wsparcie najnowszych technik dla śledzenia promieni oraz DLSS 3

- Karta jest świetnie wykonana i ma bardzo ładne podświetlanie RGB

- W zestawie znajdziemy dodatkowy, czwarty wentylator, który pozwoli na lepsze odprowadzanie ciepła z ukladu

- Za pomocą oprogramowania można zwiększyć limity TDP do 500W (domyślnie jest 450W)

- Przyzwoite OC, chociaż to w tym przypadku sztuka dla sztuki

- Aż 24GB szybkiej pamięci VRAM na 384-bitowej szynie są wręcz stworzone do grania w 4K, a nawet 8K

- Wzrosty względem poprzedniego flagowca (RTX 3090 Ti) w czystej rasteryzacji sięgają często ponad 50%

Wady

- Karta waży ok. 2 kg i wymaga wspornika, by nie wykrzywiała się w slocie PCI-E - na szczęście taki wspornik jest w zestawie

- Konieczny zasilacz o mocy co najmniej 850W z 4 wtyczkami 8-pin PCI-E

- Bardzo wysoka cena na starcie

- Niesamowity generator ciepła - należy na to zwrócić uwagę i zadbać o właściwą cyrkulację powietrza w obudowie

- Karta jest OGROMNA, w mojej obudowie przez złącze zasilania nie mogłem zamknąć szyby

- Piszczące cewki akurat w testowanym egzemplarzu

Nowe karty graficzne od NVIDIA to najmocniejsze, konsumenckie GPU, jakie kiedykolwiek pojawiły się na rynku. RTX 4090 to prawdziwa bestia, która nie boi się absolutnie żadnej gry w rozdzielczości 4K. Wydajność jest doprawdy szalona, a w połączeniu z techniką DLSS 3.0 to będzie prawdziwy potwór. Tylko nieco boli tak wysoka cena, bo reszta to jakieś drobnostki...

Przeczytaj również

Komentarze (82)

SORTUJ OD: Najnowszych / Najstarszych / Popularnych